MERIDIAN collabore avec JASCO dans la conception d’un outil de visualisation de données acoustiques sous-marines avec une composante directionnelle destiné aux biologistes et autres chercheurs. Ce système donnera la possibilité de visualiser des données collectées à partir de réseaux d’hydrophones capables de reconnaître la direction de sources sonores. Les utilisateurs pourront ainsi distinguer les différentes espèces animales et suivre les mouvements des navires et de la vie marine. Les données acoustiques sont généralement présentées aux biologistes par des spectrogrammes 2D avec des échelles de temps et de fréquence où la couleur indique l'intensité. Ceux-ci devront aussi présenter l'information directionnelle de manière conviviale pour l'utilisateur. L’expérimentation avec des couleurs directionnelles et des techniques de filtrage s’est révélée prometteuse. Nous explorons toutefois des solutions qui tirent parti de l’interaction, des visualisations tridimensionnelles ainsi que par des animations et des graphiques possédant des échelles temps-direction. Les biologistes pourront exploiter ce système pour analyser, classifier des données, prendre des notes et préparer des rapports.

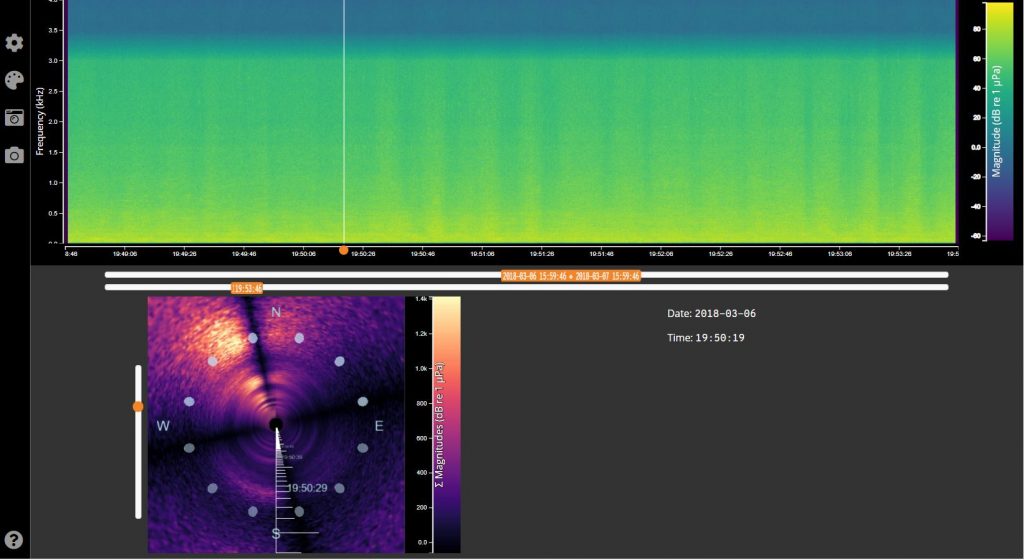

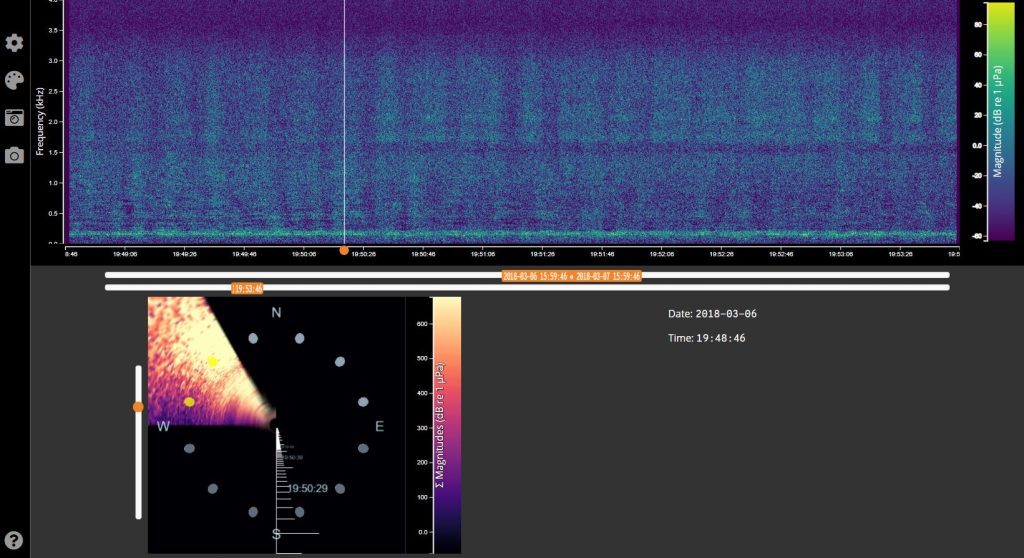

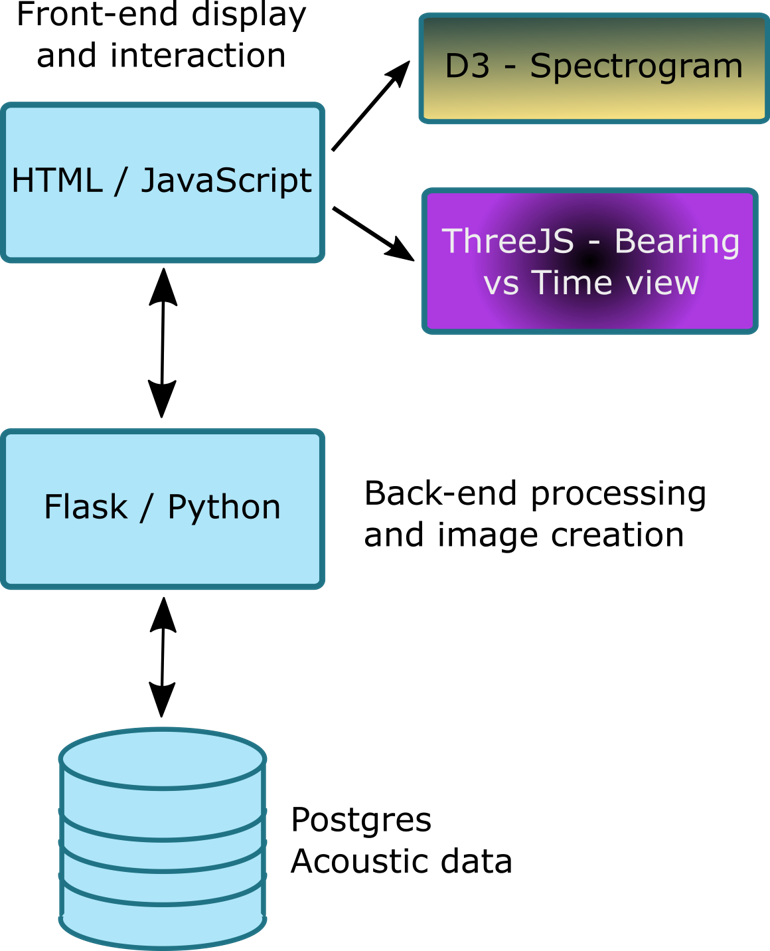

L’application donne la possibilité de visualiser des données acoustiques sur le Web sur un spectrogramme traditionnel construit avec D3. En utilisant ThreeJS, il est possible d’obtenir un graphique 3D en temps et position. Dans ce graphique, les amplitudes associées à chaque position sont additionnées, indiquant ainsi la directionnalité des sources de son. Le graphique permet à l’utilisateur de filtrer les données en fonction d’un secteur circulaire ainsi que de mettre à jour le spectrogramme en tenant seulement en compte du son associé à ces positions. Tous les calculs sont effectués sur le back-end avec Flask et Python. Les utilisateurs peuvent ajuster le temps et la fréquence, filtrer selon un secteur circulaire et télécharger des images instantanées. Les utilisateurs peuvent aussi effectuer des déplacements sur l’axe temporel du spectrogramme pour changer la position de la caméra dans le visionneur 3D.

Captures d’écran du spectrogramme et des visualisations 3D (gauche), et le filtrage d’un secteur sur un spectrogramme (droite)

La composante en matière d’apprentissage machine de ce projet examinera si les données acoustiques directionnelles à elles seules peuvent être utilisées pour estimer une position précise (amplitude et direction) d’une source sonore en utilisant des données AIS satellitaires pour produire des données d’entraînement pour un mouillage fixe. Des recherches menées entre 2017 et 2019 suggèrent qu’il est possible de localiser une source sonore en utilisant uniquement des données acoustiques à l’aide de réseaux neuronaux [1][2][3].

[1] H. Niu, E. Ozanich, P. Gerstoft, “Ship localization in Santa

Barbara Channel using machine learning classifiers”, The Journal of the

Acoustical Society of America 142, EL455, 2017, https://doi.org/10.1121/1.5010064

[2] Wang, Y. Peng, H. “Underwater acoustic source localization using

generalized regression neural network”, The Journal of the Acoustical

Society of America 143, 2018, https://doi.org/ 10.1121/1.5032311

[3] Niu, H. Zaixiao, G. Ozanich, E. Gerstoft, P. Haibin, W. Zhenglin,

L. “Deep learning for ocean acoustic source localization using one

sensor”, Journal of the Acoustical Society of America, 2019,[Online].

Available: https://arxiv.org/abs/1903.12319, [Accessed: April 7, 2019]